L'extraction de données web, également connue sous le nom de "chrome web scraping", est devenue indispensable pour les professionnels qui souhaitent collecter et analyser des informations à grande échelle. Traditionnellement, cette pratique nécessitait des compétences techniques avancées en programmation, rendant le processus inaccessible pour de nombreux utilisateurs. Aujourd'hui, grâce aux extensions Chrome dédiées au web scraping, même les personnes sans expérience en programmation peuvent extraire facilement des données structurées depuis n'importe quel site web. Ces solutions no-code transforment radicalement la manière dont les entreprises collectent et utilisent les informations disponibles en ligne, éliminant le besoin fastidieux de copier-coller manuellement des données.

Évolution du web scraping

Le web scraping existe depuis presque aussi longtemps que le web lui-même. À l'origine, cette technique était exclusivement réservée aux développeurs capables d'écrire des scripts complexes pour extraire des données de pages HTML. Ces premiers scrapers fonctionnaient généralement en analysant le code source des pages web et en utilisant des expressions régulières ou des parseurs HTML pour localiser et extraire les informations pertinentes.

Avec l'évolution du web et la démocratisation des API, certaines plateformes ont commencé à offrir des méthodes standardisées pour accéder à leurs données. Cependant, toutes les informations ne sont pas accessibles via des API, et de nombreuses entreprises continuaient à faire face à des obstacles techniques importants pour collecter des données à partir de sources multiples.

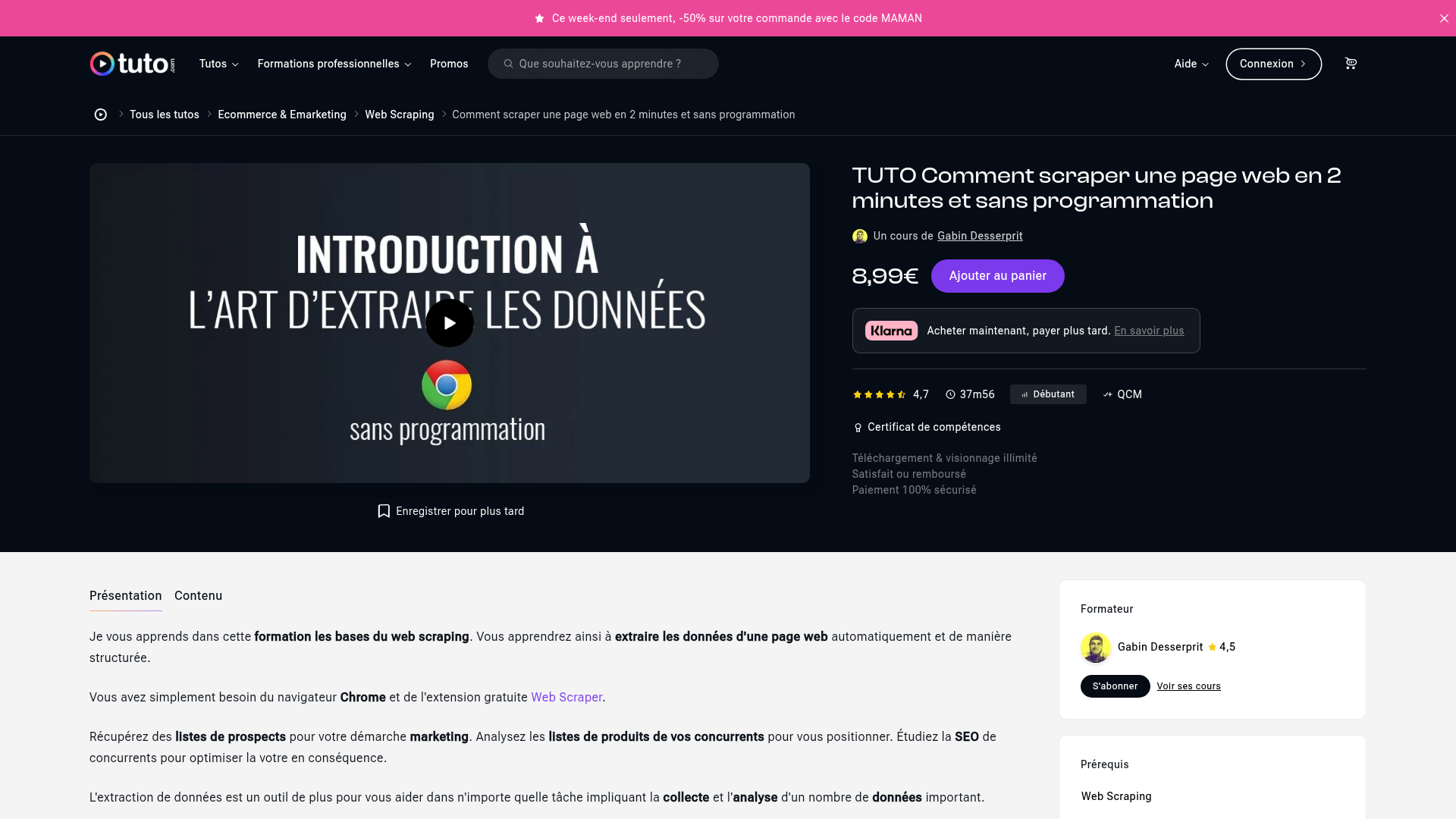

L'émergence des extensions dédiées au web scraping a marqué un tournant décisif. Ces outils ont commencé à proposer des interfaces visuelles permettant de sélectionner directement les éléments à extraire sur une page web, sans nécessiter de connaissances en programmation. Chrome, en particulier, est devenu la plateforme privilégiée pour ces solutions en raison de sa popularité et de son architecture extensible.

Aujourd'hui, nous assistons à une véritable démocratisation du web scraping avec des outils de web scraping sans code qui permettent à n'importe qui d'extraire et d'analyser des données web, quelle que soit sa formation technique.

Composants clés du web scraping avec Chrome

Pour comprendre comment fonctionne efficacement le chrome web scraping, il est essentiel de décomposer le processus en ses composants fondamentaux. Ces éléments travaillent ensemble pour transformer une tâche autrefois complexe en une opération accessible.

L'extension Chrome

Au cœur du web scraping sans code se trouve l'extension Chrome, qui sert d'interface entre l'utilisateur et le site web cible. Une extension chrome web scraping s'intègre directement dans votre navigateur, ajoutant un bouton ou une option dans le menu contextuel qui vous permet de lancer le processus d'extraction en quelques clics.

Ces extensions fonctionnent en s'exécutant dans le contexte de la page web que vous visitez, ce qui leur donne accès au DOM (Document Object Model) - la structure qui organise tous les éléments d'une page. Cette capacité est cruciale car elle permet à l'extension d'interagir directement avec le contenu affiché, sans nécessiter de serveur intermédiaire ou de configuration complexe.

Le sélecteur de données no-code

Le sélecteur de données représente l'interface visuelle qui permet aux utilisateurs d'indiquer quelles informations ils souhaitent extraire. C'est l'élément qui rend le web scraping véritablement accessible aux non-programmeurs.

Avec un web scraping plugin chrome moderne, les utilisateurs peuvent simplement pointer et cliquer sur les éléments qu'ils souhaitent extraire. Le système identifie automatiquement la structure sous-jacente et propose des sélections intelligentes. Par exemple, si vous cliquez sur un nom de produit dans une liste, l'outil peut automatiquement reconnaître tous les autres noms de produits de la même liste et suggérer de les extraire ensemble.

Cette approche visuelle élimine complètement la nécessité de comprendre des concepts techniques comme les sélecteurs CSS, XPath ou les expressions régulières, qui étaient auparavant indispensables pour le web scraping.

L'extraction et la structuration des données

Une fois les éléments sélectionnés, l'extension procède à l'extraction proprement dite des données. Cette étape va au-delà du simple copier-coller et implique une analyse intelligente du contenu pour maintenir les relations entre les différents éléments.

Les outils modernes utilisent l'intelligence artificielle pour améliorer ce processus. Ils peuvent reconnaître automatiquement les types de données (texte, nombres, dates, prix, etc.) et les structurer en conséquence. Cette capacité est particulièrement utile lorsqu'il s'agit d'extraire des tableaux complexes ou des informations dispersées sur différentes parties d'une page.

L'avantage majeur des solutions spécialisées dans l'extraction de données réside dans leur capacité à maintenir cette structure logique quelle que soit la complexité du site source.

L'automatisation du scraping

L'automatisation constitue l'étape ultime du web scraping moderne. Elle permet de transformer une extraction ponctuelle en un processus récurrent qui peut s'exécuter sans intervention humaine. Cette fonctionnalité est particulièrement précieuse pour les professionnels qui ont besoin de données actualisées régulièrement.

Les solutions d'automatisation d'extraction les plus avancées permettent de créer des workflows complets qui peuvent naviguer sur plusieurs pages, se connecter à des interfaces sécurisées, et extraire des données selon un calendrier défini. Par exemple, un responsable e-commerce peut configurer un processus automatisé pour surveiller les prix des concurrents chaque matin et recevoir les résultats directement dans son tableau de bord.

Ces automatisations peuvent également inclure des actions conditionnelles, comme l'envoi de notifications lorsque certaines conditions sont remplies, ou l'exportation automatique des données vers d'autres outils pour une analyse plus approfondie.

Meilleures pratiques pour le web scraping avec Chrome

Pour tirer le meilleur parti des outils de web scraping sous Chrome tout en respectant les bonnes pratiques, voici des recommandations essentielles pour les professionnels:

Respectez les conditions d'utilisation des sites web. Avant de commencer toute extraction, vérifiez les CGU et le fichier robots.txt du site cible pour vous assurer que le scraping est autorisé. Certains sites interdisent explicitement cette pratique ou limitent la fréquence des requêtes autorisées.

Modérez la fréquence de vos extractions. Les requêtes trop fréquentes peuvent surcharger les serveurs des sites visités. Implémentez des délais raisonnables entre les requêtes pour éviter d'être identifié comme un bot malveillant et de voir votre adresse IP bloquée.

Préparez-vous aux changements de structure. Les sites web évoluent constamment, ce qui peut briser vos configurations d'extraction. Optez pour des outils qui utilisent l'IA pour s'adapter aux changements mineurs de structure, et vérifiez régulièrement que vos extractions fonctionnent correctement.

Structurez correctement vos données dès l'extraction. Prenez le temps de définir les noms de colonnes appropriés et les types de données lors de la configuration initiale. Cette préparation en amont facilitera grandement l'analyse ultérieure. Les meilleurs outils de scraping web avec Chrome permettent de définir facilement cette structure avant même de commencer l'extraction.

Documentez vos processus d'extraction. Gardez une trace des sites que vous extrayez, de la fréquence, et des données collectées. Cette documentation est précieuse pour le respect des réglementations comme le RGPD, surtout si vous collectez des données personnelles, même indirectement.

Applications concrètes du web scraping

Le chrome web scraping offre de nombreuses applications pratiques dans divers secteurs professionnels:

Veille concurrentielle: Suivez automatiquement les prix, les promotions et les nouveaux produits de vos concurrents. Cela vous permet d'ajuster rapidement votre stratégie commerciale et tarifaire en fonction des mouvements du marché.

Génération de leads B2B: Extrayez des listes d'entreprises et leurs coordonnées à partir d'annuaires professionnels, de pages jaunes ou de sites spécialisés pour alimenter vos campagnes de prospection commerciale.

Analyse de marché: Collectez des données sur les tendances, les avis clients et les innovations de votre secteur pour identifier de nouvelles opportunités d'affaires ou améliorer vos produits existants.

Surveillance des médias: Suivez les mentions de votre marque, de vos produits ou de vos concurrents sur les sites d'actualités, les forums et les blogs pour anticiper les crises ou identifier des opportunités de communication.

Agrégation de contenu: Créez des tableaux de bord personnalisés regroupant des informations provenant de multiples sources pour faciliter la prise de décision basée sur des données actualisées.

Tendances futures du web scraping no-code

L'évolution rapide du web scraping no-code laisse entrevoir plusieurs tendances qui façonneront l'avenir de cette technologie:

L'intelligence artificielle va considérablement améliorer la précision et l'adaptabilité des outils d'extraction. Les algorithmes de machine learning permettront une reconnaissance plus intelligente des structures de pages et une adaptation automatique aux changements.

L'intégration transparente avec l'écosystème des outils métier va s'intensifier. Au-delà des exportations vers Excel ou Google Sheets, les prochaines générations d'extensions de web scraping s'intégreront nativement avec des CRM, des outils d'analyse business, et des plateformes de marketing automation.

La démocratisation des assistants IA pour le scraping transformera l'expérience utilisateur. Imaginez pouvoir simplement demander en langage naturel "Extrais tous les prix des ordinateurs portables sur ce site et compare-les avec ceux de la semaine dernière" — les futures extensions rendront cela possible.

Le traitement multimodal des données ouvrira de nouvelles possibilités. Les futurs outils pourront extraire et analyser non seulement du texte, mais aussi des images, des graphiques et même des contenus vidéo ou audio présents sur les pages web.

Transformez votre collecte de données avec Sheetly.ai

Sheetly.ai se distingue dans l'univers du web scraping par son approche centrée sur la simplicité d'utilisation sans compromis sur les fonctionnalités avancées. Cette plateforme tout-en-un permet d'extraire des données structurées depuis n'importe quelle source web en quelques clics seulement, grâce à son extension Chrome intuitive et son moteur d'intelligence artificielle puissant.

L'extension Chrome de Sheetly.ai représente le cœur de la solution, permettant d'interagir directement avec n'importe quelle page web pour sélectionner les données à extraire. Grâce à la reconnaissance intelligente alimentée par l'IA, l'outil identifie automatiquement les structures de données similaires, vous permettant d'extraire des ensembles complets d'informations en un seul clic.

La polyvalence de Sheetly.ai est particulièrement impressionnante. Au-delà des pages web classiques, l'outil peut extraire des données structurées à partir de PDF, d'images, d'Excel et de texte brut. Cette capacité multi-format élimine le besoin d'utiliser plusieurs outils spécialisés et centralise l'ensemble de vos besoins d'extraction en une seule plateforme.

Démarrer avec Sheetly.ai est extrêmement simple. Commencez par créer un compte sur Sheetly.ai pour bénéficier de l'essai gratuit de 7 jours qui vous donne accès à toutes les fonctionnalités premium sans engagement. Une fois votre compte créé, installez l'extension Chrome et commencez immédiatement à extraire les données dont vous avez besoin pour transformer votre approche analytique et gagner un temps précieux.