La collecte manuelle de données est l'un des plus grands défis auxquels sont confrontés les professionnels. Que vous soyez analyste, marketeur, commercial ou entrepreneur, vous avez probablement déjà passé des heures interminables à copier-coller des informations depuis des sites web, des documents PDF ou des feuilles Excel. Non seulement cette méthode est chronophage, mais elle est également sujette aux erreurs humaines qui peuvent compromettre la qualité de vos données. Le no code scraping représente une solution révolutionnaire à ce problème en permettant d'extraire et de structurer automatiquement des données sans compétences techniques en programmation. Cette approche démocratise l'accès à des techniques auparavant réservées aux développeurs, offrant ainsi à tous les professionnels la possibilité d'optimiser leurs flux de travail et de prendre des décisions basées sur des données fiables et actualisées.

Qu'est-ce que le scraping no-code ?

Le scraping no-code est une approche moderne d'extraction de données qui permet aux utilisateurs sans compétences en programmation de collecter automatiquement des informations à partir de diverses sources. Contrairement aux méthodes traditionnelles qui nécessitent la maîtrise de langages comme Python, JavaScript ou des bibliothèques spécialisées, les outils de web scraping no code utilisent des interfaces visuelles intuitives pour définir quelles données extraire et comment les structurer.

Le principe fondamental du no code web scraping repose sur l'identification visuelle des éléments à extraire. L'utilisateur sélectionne simplement les informations souhaitées sur une page web, et l'outil se charge automatiquement de reconnaître la structure sous-jacente et d'extraire les données correspondantes. Cette approche élimine la nécessité de comprendre le HTML, le CSS ou les API, rendant l'extraction de données accessible à tous.

Les solutions de no code scraping modernes intègrent souvent des technologies d'intelligence artificielle pour améliorer la reconnaissance des données. Ces systèmes sont capables d'identifier automatiquement les structures de données complexes, de détecter les tableaux, les listes et même d'extraire des informations à partir d'images ou de PDF scannés. Ils peuvent également s'adapter aux changements mineurs dans la structure des pages web, offrant ainsi une solution plus robuste que les méthodes traditionnelles.

En 2025, cette démocratisation de l'extraction de données a transformé la façon dont les entreprises opèrent. Selon les dernières statistiques, 73% des organisations utilisent désormais des outils de scraping pour améliorer leur prise de décision, contre seulement 45% en 2022. Cette adoption massive s'explique par l'émergence d'outils no-code performants qui ont éliminé les barrières techniques tout en offrant des capacités d'extraction puissantes.

Types et cas d'usage du scraping no-code

Le no code web scraping s'applique à une multitude de domaines professionnels et répond à des besoins variés en matière de collecte de données. Comprendre ces différents cas d'usage permet de mieux cerner le potentiel de cette technologie pour votre activité.

Dans le domaine de la prospection commerciale, les outils de scraping sans code permettent d'extraire automatiquement des listes de contacts qualifiés à partir de plateformes comme LinkedIn, de sites d'entreprises ou d'annuaires professionnels. Les équipes commerciales peuvent ainsi constituer des bases de données enrichies incluant noms, fonctions, coordonnées et autres informations pertinentes pour alimenter leur CRM et optimiser leurs campagnes d'outreach.

Pour la veille concurrentielle, ces outils offrent la possibilité de suivre en temps réel les prix, les promotions et les nouvelles offres des concurrents. Par exemple, un e-commerçant peut surveiller automatiquement les tarifs de ses concurrents sur des milliers de produits et ajuster sa stratégie tarifaire en conséquence. Cette pratique est particulièrement courante dans des secteurs hautement compétitifs comme le voyage, l'électronique ou la mode.

Les équipes marketing utilisent le scraping no-code pour analyser les tendances et identifier des opportunités de contenu. En extrayant des données depuis des forums, réseaux sociaux ou sites spécialisés, elles peuvent découvrir les questions fréquentes, les préoccupations ou les intérêts de leur audience cible. Cette intelligence collective alimente ensuite leurs stratégies de contenu et améliore le ciblage de leurs campagnes.

Dans le secteur du recrutement, les outils de scraping web permettent de constituer des viviers de talents en extrayant des profils depuis les plateformes d'emploi ou les réseaux professionnels. Les recruteurs peuvent ainsi identifier rapidement des candidats correspondant à des critères précis et enrichir leur base de données de talents.

Le scraping no-code prend en charge divers formats de données, ce qui étend considérablement son champ d'application :

- Extraction depuis des pages web (HTML) : tableaux, listes, fiches produits, articles

- Documents PDF : rapports financiers, catalogues, documentations techniques

- Fichiers Excel et CSV : transformation et enrichissement de données existantes

- Images et documents scannés : extraction de texte via OCR intégré

- Applications web dynamiques : capture de données générées par JavaScript

Cette polyvalence fait du no code web scraping une solution adaptable à pratiquement tous les besoins de collecte de données, quelle que soit leur source ou leur format.

Guide tactique du scraping no-code

Choisir le bon outil de scraping no-code

La première étape de votre parcours dans le scraping no-code consiste à sélectionner l'outil adapté à vos besoins spécifiques. Face à la multitude d'options disponibles sur le marché en 2025, plusieurs critères essentiels doivent guider votre choix.

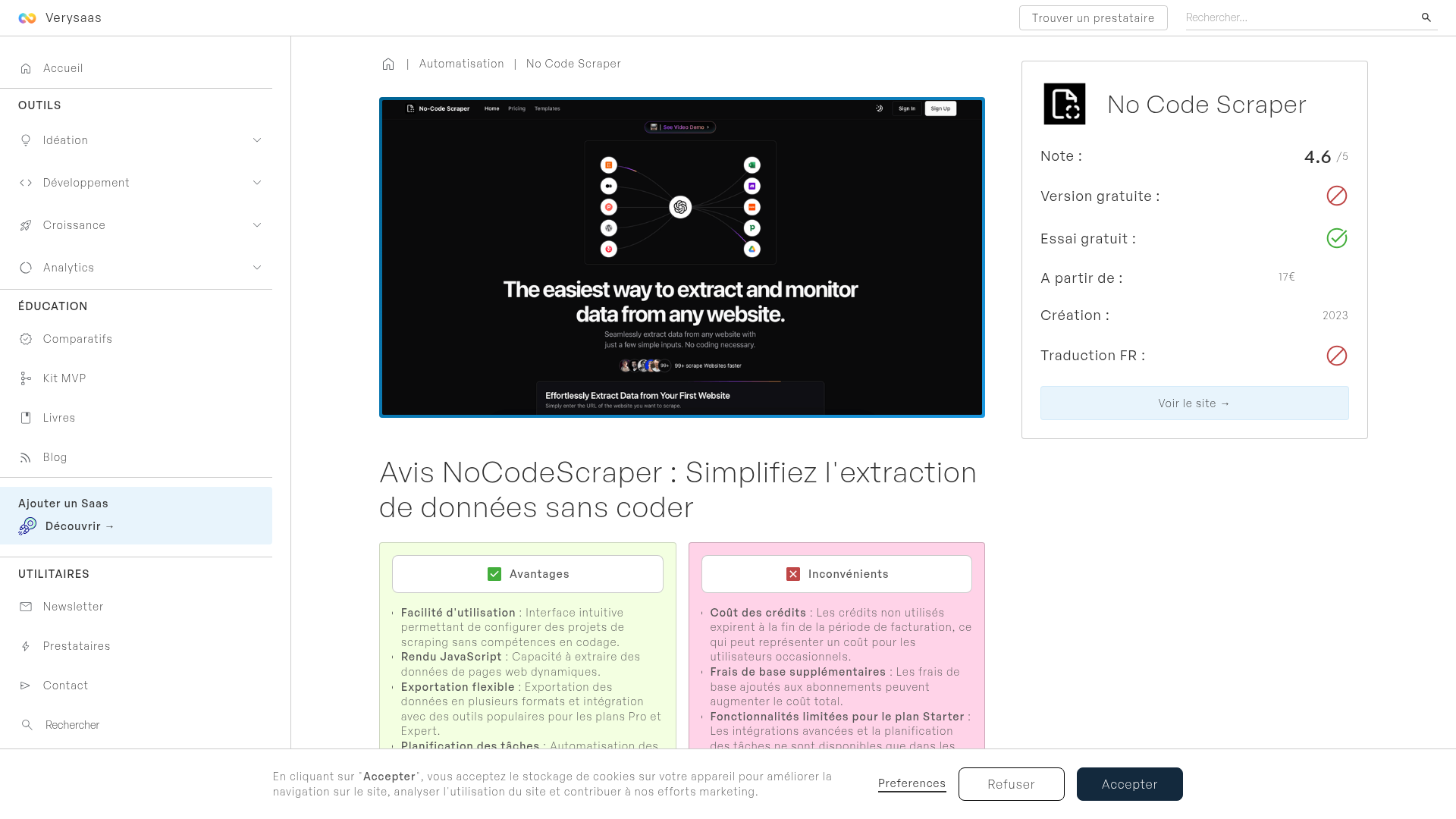

L'interface utilisateur est primordiale pour les débutants. Privilégiez les solutions proposant une expérience intuitive avec des mécanismes de sélection visuels, où l'extraction se fait par simple clic sur les éléments souhaités. Les outils dotés d'une extension de navigateur offrent généralement la meilleure expérience, permettant de sélectionner directement les données depuis les pages web visitées.

La reconnaissance intelligente des données constitue un avantage majeur. Les outils utilisant l'intelligence artificielle peuvent identifier automatiquement des structures complexes comme des tableaux, des listes de produits ou des informations de contact, réduisant considérablement le temps de configuration. Cette capacité est particulièrement utile pour extraire des données cohérentes à partir de pages aux structures variables.

La diversité des sources et formats pris en charge doit correspondre à vos besoins. Si vous travaillez régulièrement avec des PDF, assurez-vous que l'outil dispose de capacités d'extraction robustes pour ce format. De même, vérifiez la prise en charge des sites dynamiques utilisant JavaScript si vos sources primaires en dépendent.

Les options d'intégration représentent un facteur déterminant pour l'efficacité de votre workflow. Les meilleurs outils offrent des connexions directes avec vos applications existantes comme Google Sheets, Notion, Airtable ou des CRM populaires, éliminant ainsi les étapes manuelles d'importation/exportation.

Enfin, évaluez les capacités d'automatisation proposées. La possibilité de programmer des extractions récurrentes, de configurer des alertes sur les changements détectés ou de déclencher des actions basées sur les données extraites multiplie la valeur de votre investissement en réduisant davantage les interventions manuelles.

Configurer votre premier projet de scraping no-code

Mettre en place votre premier projet d'extraction de données sans code peut sembler intimidant, mais en suivant une approche méthodique, vous obtiendrez rapidement des résultats concrets. Voici comment procéder étape par étape.

Commencez par définir clairement vos objectifs d'extraction : quelles données précises recherchez-vous et comment souhaitez-vous les structurer ? Cette réflexion préalable guidera l'ensemble de votre configuration. Par exemple, pour un projet de veille concurrentielle sur des produits e-commerce, vous pourriez vouloir extraire les noms de produits, prix, disponibilités et évaluations.

Une fois vos objectifs définis, identifiez la page ou le document source contenant les informations recherchées. Pour une extraction web, naviguez vers la page cible via votre navigateur équipé de l'extension de votre outil de scraping. Pour d'autres formats (PDF, Excel), suivez le processus d'import spécifique à votre solution.

L'étape suivante consiste à sélectionner visuellement les éléments à extraire. Avec la plupart des outils no-code scraper, il suffit de cliquer sur les éléments souhaités pour les identifier. L'outil détectera automatiquement si l'élément fait partie d'une liste ou d'un tableau et proposera d'extraire toutes les occurrences similaires.

Structurez ensuite vos données en créant un modèle d'extraction cohérent. Définissez des noms explicites pour chaque champ (ex : "nom_produit", "prix", "note_client") et spécifiez le type de données attendu (texte, nombre, date, URL, etc.). Cette étape est cruciale pour assurer l'exploitabilité des informations extraites.

Avant de lancer l'extraction complète, effectuez un test sur un échantillon réduit pour vérifier que les résultats correspondent à vos attentes. Cette validation précoce vous permet d'ajuster la configuration si nécessaire et d'éviter des erreurs à grande échelle.

Automatiser et intégrer le scraping no-code

L'extraction ponctuelle de données est utile, mais l'automatisation transforme véritablement votre efficacité opérationnelle. Les outils de no code web scraping modernes offrent des fonctionnalités puissantes pour créer des workflows entièrement automatisés qui s'intègrent parfaitement à votre écosystème d'applications.

La programmation des extractions récurrentes constitue le fondement de l'automatisation. Configurez votre outil pour exécuter automatiquement vos projets d'extraction selon une fréquence adaptée à vos besoins : quotidienne, hebdomadaire ou mensuelle. Certaines plateformes permettent même des déclenchements plus sophistiqués, comme l'exécution à chaque mise à jour détectée sur une page source.

L'intégration avec les outils de productivité courants démultiplie la valeur des données extraites. En connectant votre solution de scraping à Google Sheets, les données fraîchement collectées peuvent automatiquement mettre à jour des tableaux de bord et alimenter des visualisations dynamiques. De même, une intégration avec Notion permet de créer des bases de connaissances auto-actualisées, tandis que la connexion avec Airtable offre des possibilités avancées de filtrage et de tri.

Les scénarios d'automatisation multi-étapes représentent le niveau supérieur. De nombreux outils permettent de créer des chaînes de traitement où les données extraites déclenchent automatiquement des actions spécifiques. Par exemple, lorsqu'un prix concurrent descend sous un certain seuil, le système peut générer une alerte par email ou Slack, créer une tâche dans votre outil de gestion de projet, ou même ajuster automatiquement vos propres prix via une API.

Pour maximiser l'efficacité de vos automatisations, adoptez une approche modulaire. Concevez des projets d'extraction spécialisés qui se concentrent sur une source ou un type de données spécifique, puis combinez-les dans des workflows plus larges. Cette modularité facilite la maintenance et l'évolution de votre système au fil du temps.

Optimiser votre stratégie de scraping no-code

Pour tirer pleinement parti du no code scraping, il est essentiel d'affiner continuellement votre approche et d'adopter des pratiques optimales. Ces stratégies avancées vous permettront de surmonter les obstacles courants et de maximiser l'efficacité de vos extractions.

La gestion des limitations techniques constitue un défi majeur. De nombreux sites implémentent des mesures anti-scraping comme les CAPTCHA, la limitation de débit (rate limiting) ou la détection d'empreintes digitales (fingerprinting). Pour contourner ces obstacles, privilégiez les extractions espacées dans le temps, utilisez des proxies rotatifs si votre outil les propose, et respectez les délais entre les requêtes pour simuler un comportement humain naturel.

Les créateurs de solutions recommandent d'adapter votre stratégie à la complexité de la source. Pour les sites simples et statiques, une extraction directe suffit généralement. En revanche, pour les applications web dynamiques utilisant abondamment JavaScript, privilégiez les outils capables de rendre complètement la page avant extraction ou offrant des fonctionnalités de navigation interactive.

L'enrichissement des données extraites représente une étape souvent négligée mais cruciale. Utilisez les capacités de transformation de votre outil pour standardiser les formats (dates, devises, unités), nettoyer les données superflues, et fusionner les informations provenant de sources complémentaires. Par exemple, combinez les données produits d'un site e-commerce avec les avis clients extraits d'une plateforme distincte pour obtenir une vue plus complète.

Pour les projets d'extraction à grande échelle, adoptez une approche progressive. Commencez par un échantillon représentatif pour valider votre configuration, puis étendez progressivement la portée. Cette méthode permet d'identifier précocement les problèmes potentiels et d'ajuster votre stratégie avant de mobiliser des ressources importantes.

Points clés et conclusion

Le scraping no-code représente une véritable révolution dans le domaine de l'extraction de données, démocratisant des capacités autrefois réservées aux experts techniques. À travers ce guide, nous avons exploré les fondamentaux de cette approche accessible et puissante, ses applications variées et les stratégies pour l'implémenter efficacement dans votre activité professionnelle.

Le no code web scraping élimine les barrières techniques traditionnelles, permettant à quiconque de configurer visuellement des extractions de données complexes. Cette démocratisation explique pourquoi 73% des entreprises utilisent désormais ces techniques pour améliorer leur prise de décision, contre seulement 45% il y a trois ans.

Les cas d'usage sont innombrables : de la prospection commerciale à la veille concurrentielle, en passant par l'enrichissement de bases de données et l'automatisation de tâches répétitives. Quelle que soit votre industrie, le scraping no-code offre des opportunités concrètes d'optimisation et de gain de temps.

Pour les professionnels cherchant à éliminer définitivement le copier-coller manuel de leur quotidien, Sheetly.ai offre une solution complète de scraping no-code particulièrement adaptée aux débutants. Avec son extension Chrome intuitive, sa reconnaissance intelligente dopée à l'IA et ses intégrations fluides avec les outils de productivité courants, Sheetly.ai répond précisément aux besoins identifiés tout au long de ce guide.